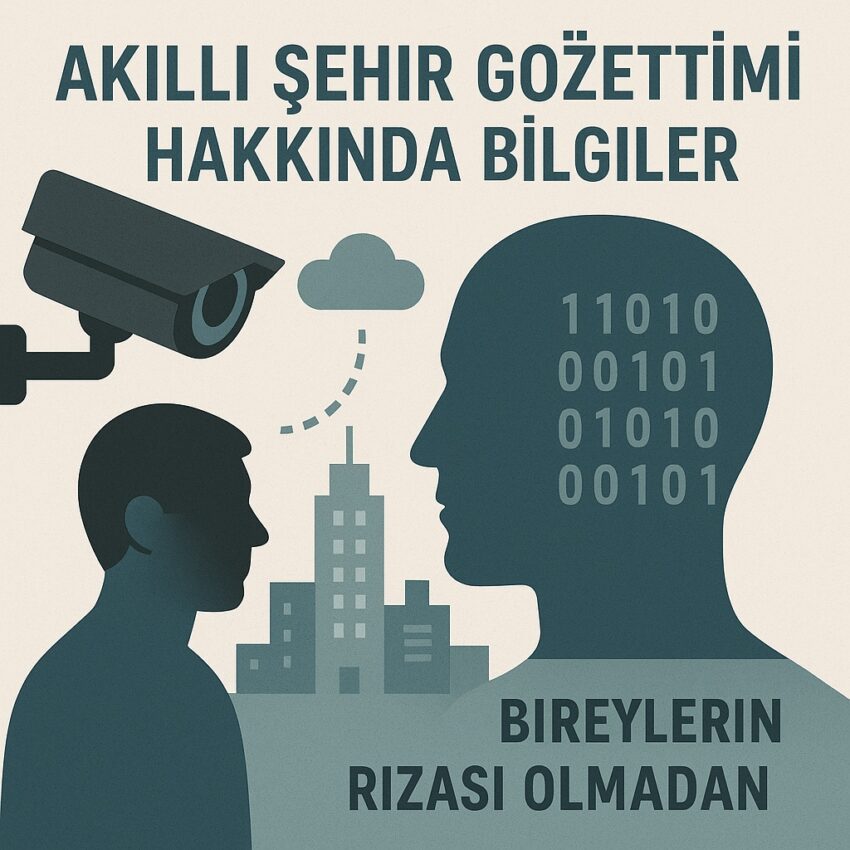

Akıllı Şehir Gözetimi Hakkında Bilmediğiniz 4 Şaşırtıcı Gerçek

Giriş: Akıllı Şehir Rüyası ve Gözden Kaçan Gerçekler.

Akıllı şehirler, teknolojiyle donatılmış, daha güvenli sokaklar, verimli bir yaşam ve artan bir konfor vaat ediyor. Yapay zeka destekli kameraların suçu önlediği, sensörlerin trafiği akıcı hale getirdiği bir gelecek hayal ediliyor. Ancak bu parlak tablonun ardında, madalyonun diğer yüzünde, genellikle gözden kaçan şaşırtıcı, karşı-sezgisel ve derin zorluklar yatıyor.

Bu teknoloji, sandığımızdan çok daha karmaşık etik ve sosyal soruları beraberinde getiriyor. Bu yazı, akıllı şehirlerin ve yapay zeka destekli güvenliğin size söylemediği, gözden kaçan gerçekleri ortaya çıkaracak.

“Vazgeçme” Seçeneğiniz Yok: Gözetimden Kaçmak İmkansız.

Akıllı şehirlerdeki gözetimin belki de en şaşırtıcı yönü, bireylerin bu sistemin dışında kalma (opt-out) seçeneğinin fiilen olmamasıdır. Akıllı şehirlerde sensörlerin ve kameraların her yere yayılmış olması, gözetimi neredeyse kaçınılmaz ve istemsiz (involuntary) bir hale getirir. Bu durum, bir hizmeti kullanmayı bırakarak veya bir çerezi reddederek “vazgeçme” seçeneğine sahip olduğumuz çevrimiçi gizlilikten temelden ayrılır.

Kamusal alana adım attığınız anda, rızanız olmaksızın bir veri noktasına dönüşürsünüz. Bu sadece bir rahatsızlık değil, aynı zamanda temel bir yasal çatışmadır. Örneğin, Avrupa Birliği’nin GDPR gibi katı gizlilik yasaları, kişisel verilerin rıza olmadan toplanmasını yasaklar. Gözetimin bu “istemsiz” doğası, yaygın yüz tanıma sistemlerini mevcut yasal çerçevelerle doğrudan çelişkiye düşürür.

Sürekli izlenme durumu, bireyin özerkliği ve özgürlüğü üzerinde kısıtlayıcı bir etki yaratırken, insanlarda doğal olmayan bir özbilinç ve huzursuzluk hissine yol açabilir. Bir uzmanın bu hissi tanımlamak için kullandığı ifade, durumu mükemmel bir şekilde özetliyor: “tüm gün sizinle yürüyen bir polis memuru”

%100 Doğruluk Bir Efsane: Yapay Zeka Her Zaman Hata Yapar.

Yapay zekanın yanılmaz bir teknoloji olduğu yönündeki yaygın kanı, tehlikeli bir yanılgıdır. Gerçekte, yüz tanıma dahil olmak üzere yapay zeka güdümlü sistemler her zaman bir hata payı ile çalışır ve %100 doğruluk sağlamak gerçekçi değildir. Günümüz teknolojilerinde bu hata payı yaklaşık %0,1 (binde bir) civarındadır.

Bu oran kulağa çok düşük gelse de, milyonlarca insanın yaşadığı bir şehirde kitlesel olarak uygulandığında, her gün binlerce masum insanın yanlış teşhis edilmesi (false positive) veya gerçek suçluların gözden kaçırılması (false negative) anlamına gelebilir. Daha da endişe verici olanı ise algoritmaların, ancak eğitildikleri veriler kadar adil olabilmesidir. Eğer bir sistem ağırlıklı olarak Kafkas yüzleriyle eğitilmişse, farklı etnik kökenlere sahip kişileri tanımada daha az başarılı olacaktır.

Bu durum, teknolojinin tarafsız bir gözlemci olma vaadini boşa çıkararak, mevcut toplumsal önyargıları dijital dünyada pekiştiren ve hatta otomatikleştiren tehlikeli bir araca dönüşmesine neden olur. Bir fütürist bakış açısıyla, bu sorunun çözümü, algoritmaların tüm etnik kökenleri kapsayan çeşitli ve temsili veri setleriyle eğitilmesinden geçse de, bu teknolojik sınırlamalar adalet ve eşitlik gibi temel değerler için ciddi riskler oluşturmaktadır.

“Kara Kutu” Problemi: Geliştiriciler Bile Nedenini Bilmiyor.

Yapay zekanın en kafa karıştırıcı ve endişe verici yönlerinden biri, karar mekanizmalarının şeffaf olmamasıdır. Derin öğrenme modelleri, bir sonuca nasıl ulaştıklarını insanlar için, hatta çoğu zaman kendi geliştiricileri için bile tam olarak anlaşılır bir şekilde açıklayamaz. Bu yüzden bu süreç, içi görünmeyen bir “kara kutu” (black box) olarak tanımlanır.

Örneğin, bir yüz tanıma sistemi iki fotoğraf arasında bir eşleşme bulduğunda, bu kararı tam olarak hangi yüz özelliklerine dayanarak verdiğini açıklayamayabilir. Yanlış bir eşleşme durumunda, polisin veya yetkililerin teknolojinin neden hata yaptığını açıklayamaması, ciddi hukuki boşluklar ve hesap verebilirlik sorunları yaratır. Sistem bir hata yaptığında sorumluluk kime aittir?

Algoritmaya mı, veriye mi, yoksa uygulayıcıya mı? Bu şeffaflık eksikliği, adil yargılanma hakkını tehlikeye atar. Bu zorluğun üstesinden gelmek için, “Açıklanabilir Yapay Zeka (Explainable AI)” gibi yeni alanlar, bu kara kutuları daha şeffaf hale getirmek ve teknolojinin kararlarını insanlara anlaşılır kılmak için aktif olarak çalışmaktadır.

Amaç Kayması: Güvenlik Kameranız Başka Ne İçin Kullanılıyor?

“Function creep” veya “amaç kayması” olarak bilinen risk, iyi niyetle kurulan sistemlerin zamanla sinsi bir şekilde amacını aşmasıdır. Bu, bir gözetim sisteminin başlangıçta belirlenen meşru bir amaç için kurulup, zamanla bu amacın dışına taşarak ilgisiz başka amaçlar için kullanılmaya başlanması anlamına gelir.

Rotterdam’da yaşanan bir olay bu durumu somutlaştırmaktadır: Bir festivalin güvenliği için kiralanan kameralı araçlar, etkinlik bittikten sonra COVID-19 protestolarını izlemek ve katılımcılara para cezası kesmek için kullanılmıştır. Bu tür amaç kaymaları, sadece basit bir güven sorunundan ibaret değildir; vatandaşlar ile yetkililer arasındaki zımni toplumsal sözleşmenin ihlalidir.

Başlangıçta kamu yararı için kurulduğu söylenen bir teknolojinin, zamanla vatandaşları denetleyen ve cezalandıran bir araca dönüşmesi, devlete ve teknolojiye olan güveni temelden sarsarak toplumsal güvensizlik ve dirence yol açar.

Sonuç: Akıllı Şehirler mi, Gözetleyen Şehirler mi?

Akıllı şehirlerin geleceğini şekillendirmek, sadece daha hızlı işlemciler ve daha net kameralar geliştirmekten ibaret bir teknoloji yarışı değildir. Bu süreç, temelde özgürlük ve güvenlik gibi iki hayati değer arasında nasıl bir denge kurmak istediğimize dair derin bir toplumsal tercihi zorunlu kılar. Parlak bir gelecek vaadiyle atılan her teknolojik adım, bizi bu temel soruyu sormaya itiyor:

Teknolojinin sınırlarını zorlarken, gerçekten “akıllı” şehirler mi inşa ediyoruz, yoksa sadece her anımızı “gözetleyen” şehirler mi?